文章目录

- Abstract:

- 1 Introduction

- 2 Related work

- 3 Proposed framework

- 4 Experimental results

-

- 4.1 Experimental settings

- 4.2 Network architecture

- 4.3 Experimental results and comparison

-

- 4.3.1 Our results:

- 4.3.2 Comparison with ground truth images in details:

- 4.3.3 Comparison with other models:

- 4.3.4 Creating new fonts:

- 4.3.5 Images quality analysis:

- 4.3.6 Parameter tuning:

- 5 Conclusion

- 6 Acknowledgement

- 7 References

Abstract:

由于汉字结构复杂,汉字数量巨大,设计新的汉字字体对艺术家来说非常具有挑战性和耗时性。因此,汉字的生成和字形的转换成为研究热点。目前,大多数汉字转换模型无法生成多个字体,在伪造字体方面也做得不好。本文提出了基于生成对抗网络的汉字字体转换和生成方法。如果作者结合现有字体的特点,作者模型可以通过字体样式的指定机制一次生成多个字体。

1 Introduction

汉字数量与英文字母数量有明显差异。只有26个小写英文字母和26个大写字母。然而,根据GB18030-2000标准,至少有27533个不同的汉字,其中3000个常用。除了大量的汉字,它们还有不同的结构成分,包括笔划、部首、分类等。由于汉字字体的复杂性,研究人员在汉字字体生成方面进展甚微。在过去,有人提出了一些方法,如[1-3],将每个汉字视为字根和笔划的组合,我们可以结合不同的字根和笔划来构建一个新的汉字。在[4]中,作者使用基于笔划的方法通过递归神经网络生成汉字字体。2014年[5]生成对抗网络(GAN)的出现,Zi2Zi已开发出模型。通过训练识别器和生成器Zi2Zi尽管有些字体图像模糊,但模型可以生成各种字体。

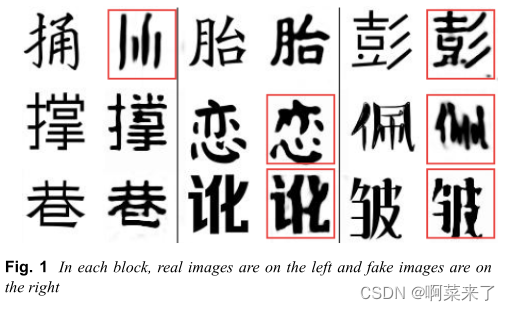

一般来说,以前的方法存在一些问题。首先,一些生成字体的图像模糊(图1)。其次,模型不能同时生成多个字体,即在给定的训练数据集中,它们只能生成一个字体。如果我们想生成多个字体,我们需要训练多个模型。最后,但最不重要的是,模型不能生成新字体,只能生成现有字体。与其他方法相比,如图2所示。

为了解决这些问题,我们提出了一个新的模型。我们的模型是基于GAN,它只包括一个识别器、一个生成器和一个字体风格的指定机制。通过指定的机制,我们可以一次生成各种不同风格的汉字。此外,我们的模型可以结合不同的字体风格生成新的字体。

我们的主要贡献如下:

- 我们提出了一种生成汉字字体的新方法。该方法可以同时生成具有多个指定字体的中文字体,并结合不同字体生成新的字体样式,优于现有工作[6、7]

- 我们改进了我们的模型GAN并引入了字体风格的指定机制,使生成器能够学习不同的字体风格,并根据指定的信息生成汉字

- 我们的识别器也不同于一般的识别器GAN。我们的识别器具有识别和分类功能,可以预测汉字的风格

- 我们对几个汉字数据集进行了综合实验。实验结果表明,该模型可以生成高质量的多风格汉字图像和新的汉字图像。

本文的其余部分如下。第二节简要讨论了相关工作。我们提出的模型在第三节。实验结果见第四节,结论见第五节。

2 Related work

汉字生成和汉字字体转换。以前的汉字生成和风格转换方法,如[1-3],将汉字视为部首和笔划的组合。这些方法需要收集许多不同风格的部首和笔画来构建汉字。最近,一些流行的方法,如[8],使用完整的汉字图像作为输入,使用端到端生成和应用GAN生成汉字。然而,Zi2Zi无法指定要生成的字体,该方法存在一些图像模糊的问题。作者通过阅读少数例子[9]学习书写风格化汉字,介绍了不同的风格库。打开输入汉字的字体样式和内容,将内容与来自样式库的不同样式相结合。该方法的缺点是需要提前收集和训练样式库。这意味着我们需要很多时间来准备数据。转换中文布局(CTT)[10]作者使用赣端到端生成汉字。一次只能将一个字体转换成另一个字体。假如我们需要多种字体,则需要训练多种模型。本文使用深度神经网络[11]一次性生成任意风格的汉字,使用深度神经网络生成汉字。虽然所谓的相应风格字体可以通过训练样本(一次)生成,但实际上表明新生成的图像与地面真实图像之间存在巨大差异,因为样本不能真正提取汉字字体的所有特征。

GAN 近年来,氮化镓在生成高质量图像方面取得了巨大成就。典型的氮化镓模型由发生器和识别器组成。生成器生成图像,识别器识别图像是真实的还是我们生成的。随着GAN根据不同的任务,有许多不同版本的模型。例如,周期GAN[12]和DiscoGAN[13]解决了源域与目标域之间转换的不匹配问题。StarGAN[14]是GAN另一个版本用于人脸转换任务。人脸图像的某些细节可以根据用户指定的信息进行更改。大GAN[6]实验结果表明,使用更多的训练样本和一些截断技能有助于使用GAN生成高质量的图像。

对抗性学习。对抗学习有几本书。生成散列对手(HAG)[15]中,HAG对手示例可以通过小扰动成功构建,误导目标散列模型。在幻觉IQA在[16]中,作者提出了质量回归网络的幻觉指导,以解决无参考图像质量评价中的有限信息。在RAN4IQA这种方法受到自由能脑理论的启发,这意味着人类视觉系统(HVS)在看到扭曲的图像时,往往会减少不确定性,恢复感知细节。因此,作者提出了由恢复模块、识别器和评估器三部分组成的恢复对抗网络HVS过程。

受Zi2Zi和StarGAN受启发,我们设计了一个新模型来生成不同的汉字字体,并结合各种汉字风格来创建一个新的字体。我们的方法有三个步骤。 [图3我们模型的框架。在数据准备部分,通过样式指定机制将热编码的输入图像和标签合并成矩阵(64×64×(3 n))。生成器获取新矩阵并输出假图像。识别器有两个功能,一个是区分真假图像,另一个是分类图像]

3 Proposed framework

本节将解释我们的实验框架是如何工作的(图3)。问题公式。让x、y、t和c分别表示输入图像、伪图像、基本真实图像和目标字体样式标签。G为发电机,G x,c→ y意味着将x和c结合G生成假图像y。假设识别器是D和D x→ Ddis x,Dcls x表示将图像x送入识别器。Ddis指D生成的图像是否真实的结果。Dcls是D生成的目标字体标签的概率分布。

我们的模型由生成器组成G、由识别器D和样式指定机制组成。首先,我们使用样式指定机制将输入图像与字体标签组合成矩阵。然后,我们将矩阵输入生成器,生成器生成伪图像。最后,识别器识别图像是真是假,并预测字体样式。我们设计了对抗性损失、字体风格分类损失和语义一致性损失三种损失函数,以获得理想的实验结果。我们将详细介绍这三个功能的功能。

对抗损失。以下是基本的对抗损失函数[18],以确保生成器生成的图像能够愚弄识别器 其中,D试着区分G生成的真实图像和真实图像。我们使用t作为监督,使D具有最大的区分能力。

这个损失函数是为了帮助G制作照片逼真的图像来愚弄识别器 让G尽量减少这个目标 字体分类丢失。监督背景真值图像t和背景真值标签c,让D通过最小化以下目标来学习字体分类。Dcls c′t目标字体标签上的概率分布由D计算。损失定义为:

假图像字体分类的损失函数定义为: G为了生成将被归类为目标标签的虚假图像,试图最小化目标。

梯度惩罚。我们使用梯度惩罚[7]来获得更快的收敛速度,并生成更高质量的照片级真实样本。x′表示梯度。α是超参数。损失定义为:

语义一致性丢失。在我们的模型中,我们希望生成与给定汉字相同的汉字,所以我们使用它L1损失[19]函数。语义一致性损失定义为: 最小化这个目标可以保持G内容的一致性. 最终优化目标函数。结合所有损失函数,我们将最终优化目标函数训练为:

其中λadv、λfest和λcls它用于损失的权重,以便在语义、分类和适应失的权重的权衡。

算法。我们为每个字体指定一个数字作为标签,例如,宋体样式为0,黑体样式为1,凯体样式为2,梨树样式为3,新纬样式为4,舒体样式为5,兴凯样式为6。然后我们将每个标签转换为一个热向量。我们将图像矩阵和标签向量合并在一起,生成包含字体信息的新图像矩阵。新图像矩阵的形状为64×64×(3+n),其中n表示类的总数。我们将新的图像矩阵输入到G中,G生成没有字体标签(64×64×3)的新伪图像y。接下来,我们将y发送到D,让D判别y是否虚假,并对y的字体进行分类。我们使用真实图像t和虚假图像y的L1损失、虚假图像y的字体分类损失以及真实和虚假图像的对抗性损失来优化G的参数。D的参数通过真实图像t的对抗性损失、字体损失分类来优化,梯度惩罚。通过随机梯度下降更新参数。我们使用Adadelta作为G和D的参数优化算法。该算法如图4所示。

4 Experimental results

在本节中,我们将说明实验的细节和结果。

4.1 Experimental settings

我们使用来自Zi2Zi的font2img脚本生成中文字体数据集。11个汉字字体数据集包括:宋体、黑体、楷体、隶书体、新卫体、书体、兴凯体、道风体、黄草体、叶根草书体、张草体。我们为每个数据集生成3498个汉字,这使得它总共有38478个汉字图像。我们将每个字符的图像大小设置为64×64×3。我们为每个字体指定一个数字作为标签,例如,宋体样式为0,黑体样式为1,楷体样式为2,隶书样式为3,新卫样式为4,舒体样式为5,兴凯样式为6等等。然后我们将每个标签转换为一个热向量。

为了让生成器知道我们指定的字体,我们将输入图像和标签连接在一起。因此,图像的输入大小更改为64×64×(3+n),而输出大小保持为64×64×3。

4.2 Network architecture

受Zi2Zi、StarGAN和ADDA[19]的启发,我们的模型有一个样式指定机制、一个生成器和一个鉴别器,具有识别和分类能力。生成器网络(表1)由三个卷积块、六个残差块[20]和三个转置卷积块组成。我们对每个卷积层使用实例归一化,并遵循整流线性单元(Relu)激活函数。

鉴别器网络(表2中)由六个卷积块和两个全卷积网络组成。每个卷积块包含一个卷积层和一个LeakyRelu激活函数。其中一个全卷积网络用于区分真假图像,另一个用于分类字体。

4.3 Experimental results and comparison

在本节中,我们将展示我们的实验结果,并将我们的结果与其他模型进行比较。

4.3.1 Our results:

我们选择一种字体作为源字体,六种字体作为目标来训练我们的模型。我们对每种字体重复这个过程,并使用指定的字体生成高质量的图像。我们生成了多种不同的字体。我们制作的图像具有清晰的图形结构和笔划。结果表明,该模型对不同字体具有较强的学习和生成能力。使用Songti样式生成的真实图像和照片真实图像如图5所示。 假图像的字体与我们指定的相同。与真实图像相比,我们的假图像具有真实感、完整性和清晰性。比较结果如图6所示。

4.3.2 Comparison with ground truth images in details:

在本节中,我们将生成的图像的细节与真实图像进行比较,发现细节学习非常成功。比较结果如图7所示。

4.3.3 Comparison with other models:

与其他只能生成一种字体的模型(如Zi2Zi和CTT)相比,我们的模型可以使用一种源字体成功地生成多个目标字体,并生成清晰的字体图像。比较结果如图所示。8和9。我们的模型可以得到一种字体的图像(宋体或其他字体),并输出多个目标字体,如舒提、兴凯等。通过比较,我们可以发现,我们的模型生成的图像质量在视觉上也优于其他模型。

4.3.4 Creating new fonts:

理论上,组合字体的能力使我们的模型能够生成ℂ11 2 + ℂ11 3 + ⋯ + ℂ11新字体。但是,如果两种字体相差过大,将它们组合在一起会导致图像模糊。我们选择了一些清晰的图像。结果如图所示。具体来说,图10显示了输入字体和新生成的输出字体,而图11显示了通过组合两种字体生成的新字体。

4.3.5 Images quality analysis:

为了评估生成图像的质量,我们使用结构相似性(SSIM)指数[21]和余弦相似性(CosSim)[22]作为标准评估指标。SSIM是图像失真的度量。分数越高,描述越清晰。CosSim用于测量两幅图像之间的像素间隙。分数越高,图片越相似。我们的模型与对应的CTT和Zi2Zi的定量比较如表3所示。我们可以观察到,在这两个评估指标上,我们的模型与现有的两种方法相比获得了更好的性能,表明了它在给定样式信息的情况下生成更准确的字体图像的有效性。

4.3.6 Parameter tuning:

为了获得更好的实验结果,我们尝试了图12中所示的损耗曲线的不同超参数。图13显示了不同λrec的损耗曲线的比较。从这些图中可以看出,当λcls和λadv固定时,损耗值随λrec的增加而减小。太多λrec。会议导致字体样式的丢失。同时,过多的λcls会导致图像质量下降,而λadv太大会导致学习不足,λadv太小会导致收敛太慢。我们需要权衡λcls、λadv和λrec之间的值。小心经过多次调整和实验,最终得到了损耗值的最佳结果∼0.0912,使用λrec.=20,λcls=10和λadv.=1.

5 Conclusion

在本文中,我们提出了一种新的模型来进行一对多汉字字体转换,并通过组合现有字体生成新字体。我们使用了11种字体的数据集来训练模型,并生成了清晰逼真的图像。与现有的Zi2Zi和CTT方法相比,我们的模型可以生成更高质量的图像。通过使用梯度惩罚,我们可以使图像更清晰。与创建字体的传统艺术家不同,我们提取现有字体样式的特征,并通过组合现有字体样式的特征来创建新字体。我们在图像限制损失、字体分类损失和对抗性损失之间建立了平衡关系。我们的模型可用于不同字体,与再次修改和训练模型相比,此功能节省了大量时间。

6 Acknowledgement

本研究得到了国家自然科学基金61602089、61673088的部分资助;江西师范大学博士研究基金(编号:0901 /12019572)。

7 References

[1] Xu, S., Jiang, H., Jin, T., et al.: ‘Automatic generation of Chinese calligraphic writings with style imitation’, IEEE Intell. Syst., 2009, 24, (2), pp. 44–53, DOI: 10.1109/MIS.2009.23 [2] Xu, S., Jin, T., Jiang, H., et al.: ‘Automatic generation of personal Chinese handwriting by capturing the characteristics of personal handwriting’. Proc. of the Twenty-First Conf. on Innovative Applications of Artificial Intelligence, Pasadena, California, USA, 14–16 July 2009 [3] Zhou, B., Wang, W., Chen, Z.: ‘Easy generation of personal Chinese handwritten fonts’. Proc. of the 2011 IEEE Int. Conf. on Multimedia and Expo, ICME 2011, Barcelona, Catalonia, Spain, 11–15 July 2011, pp. 1–6 [4] Zhang, X.-Y ., Yin, F., Zhang, Y .-M., et al.: ‘Drawing and recognizing Chinese characters with recurrent neural network’, IEEE Trans. Pattern Anal. Mach. Intell., 2018, 40, (4), pp. 849–862 [5] Goodfellow, I.J., Pouget-Abadie, J., Mirza, M., et al.: ‘Generative adversarial networks’, CoRR, vol. abs/1406.2661, 2014 [6] Brock, A., Donahue, J., Simonyan, K.: ‘Large scale GAN training for high fidelity natural image synthesis’, CoRR, vol. abs/1809.11096, 2018 [7] Gulrajani, I., Ahmed, F., Arjovsky, M., et al.: ‘Improved training of Wasserstein GANs’. Advances in Neural Information Processing Systems 30: Annual Conf. on Neural Information Processing Systems 2017, Long Beach, CA, USA, 4–9 December 2017, pp. 5769–5779 [8] Tian, Y .: ‘Zi2zi: master Chinese calligraphy with conditional adversarial networks’, 2017 [9] Sun, D., Ren, T., Li, C., et al.: ‘Learning to write stylized Chinese characters by reading a handful of examples’. Proc. of the Twenty-Seventh Int. Joint Conf. on Artificial Intelligence, IJCAI 2018, Stockholm, Sweden, 13–19 July 2018, pp. 920–927 [10] Chang, J., Gu, Y ., Zhang, Y .: ‘Chinese typography transfer’, CoRR, vol. abs/ 1707.04904, 2017, Withdrawn [11] Jiang, H., Y ang, G., Huang, K., et al.: ‘W-net: one-shot arbitrary-style Chinese character generation with deep neural networks’. Neural Information Processing – 25th Int. Conf., ICONIP 2018, Siem Reap, Cambodia, Proceedings, Part V , 13–16 December 2018, pp. 483–493 [12] Zhu, J.-Y ., Park, T., Isola, P ., et al.: ‘Unpaired image-to-image translation using cycle-consistent adversarial networks’. IEEE Int. Conf. on Computer Vision, ICCV 2017, V enice, Italy, 22–29 October 2017, pp. 2242–2251 [13] Kim, T., Cha, M., Kim, H., et al.: ‘Learning to discover cross-domain relations with generative adversarial networks’. Proc. of the 34th Int. Conf. on Machine Learning, ICML 2017, Sydney, NSW, Australia, 6–11 August 2017, pp. 1857–1865 [14] Choi, Y ., Choi, M.-J., Kim, M., et al.: ‘Stargan: unified generative adversarial networks for multi-domain image-to-image translation’. 2018 IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2018, Salt Lake City, 2018, pp. 8789–8797 [15] Y ang, E., Liu, T., Deng, C., et al.: ‘Adversarial examples for hamming space search’, IEEE Trans. Cybern., 2018, pp. 1–12 [16] Lin, K.-Y ., Wang, G.: ‘Hallucinated-iqa: no-reference image quality assessment via adversarial learning’. IEEE Conf. on Computer Vision and Pattern Recognition, Salt Lake City, 2018, pp. 732–741 [17] Ren, H., Chen, D., Wang, Y .: ‘RAN4IQA: restorative adversarial nets for no- reference image quality assessment’. AAAI Conf. on Artificial Intelligence, New Orleans, Louisiana, USA, 2018, pp. 7308–7314 [18] Goodfellow, I.J., Pouget-Abadie, J., Mirza, M., et al.: ‘Generative adversarial nets’. Advances in Neural Information Processing Systems 27, Montreal, Quebec, Canada, 8–13 December 2014, pp. 2672–2680 [19] Tzeng, E., Hoffman, J., Saenko, K., et al.: ‘Adversarial discriminative domain adaptation’. 2017 IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2017, Honolulu, HI, USA, 21–26 July 2017, pp. 2962–2971 [20] He, K., Zhang, X., Ren, S., et al.: ‘Deep residual learning for image recognition’. 2016 IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2016, Las V egas, NV , USA, 27–30 June 2016, pp. 770–778 [21] Sheikh, H.R., Wang, Z., Bovik, A.C.: ‘Image quality assessment: from error visibility to structural similarity’, IEEE Trans. Image Process., 2004, 13, (4), pp. 600–612, DOI: 10.1007/978-3-642-19309-5_55 [22] Nguyen, H.V ., Bai, L.: ‘Cosine similarity metric learning for face verification’. Asian Conf. on Computer Vision, Queenstown, New Zealand, 2010, https://ieeexplore.ieee.org/document/8573146