Meta Graph Transformer: A Novel Framework for Spatial–Temporal Traffic Prediction

原文,见此 作者:Xue Ye , Shen Fang , Fang Sun , Chunxia Zhang , Shiming Xian 期刊:爱思唯尔Neurocomputing 关键词:交通预测、时空建模、元学习、注意机制、深度学习 相关博文:翻译 代码:https://github.com/lonicera-yx/MGT 或 gitee code

文章目录

- Meta Graph Transformer: A Novel Framework for Spatial–Temporal Traffic Prediction

-

- bib

- 知识点参考

- 摘要

- 1. Introduction

- 2. Related Work

-

- 2.1. Spatial–Temporal Traffic Prediction

- 2.2. Attention Mechanism

- 3. Preliminaries

-

- 3.1. Problem Formulation

- 3.2. Multi-Head Attention

- 4. Meta Graph Transformer

- 4.1. Overall Pipeline

-

- 4.2. Spatial–Temporal Embeddings

-

- 4.2.1. Temporal Embeddings

- 4.2.2. Spatial Embeddings

- 4.2.3. Spatial–Temporal Embeddings

- 4.3. Transition Matrices

-

- 4.3.1. Construction of Multiple Graphs

- 4.3.2. Transition Matrices

- 4.4. Encoder

-

- 4.4.1. Temporal Self-Attention

- 4.4.2. Spatial Self-Attention

- 4.4.3. Feed Forward Network

- 4.5. Decoder

-

- 4.5.1. TSA with Mask

- 4.5.2. Temporal Encoder-Decoder Attention

- 5. Experiments

-

- 5.1. Datasets

- 5.2. Experimental Settings

- 5.3. Baseline Methods

- 5.4. Experimental Results and Analysis

- 5.5. Comparison on rush hours

- 5.6. Ablation Study

-

- 5.6.1. Analysis in view of Temporal and Spatial Message Passing

- 5.6.2. Analysis in view of Temporal and Spatial Heterogeneity

- 5.6.3. Analysis of Transition Matrices

- 5.7. Analysis of Hyperparameters

-

- 5.8. Model Size Comparison

- 5.9. Efficiency Study

- 6. Conclusion

- Fig5-->10

bib

@article{2021Meta, title={Meta Graph Transformer: A Novel Framework for Spatial–Temporal Traffic Prediction - ScienceDirect}, author={ Xue, Yab and Shen, Fab and Fang, S. C. and Cz, D and Sxa, B }, journal={Neurocomputing}, volume={491}, pages={544-563}, year={2021}, } 知识点参考

- Laplacian Eigenmaps:四大机器学习降维算法, 推导方法,不完整csdn》

摘要

准确的交通预测是提高智能交通系统性能的关键。这项任务的如何正确建模复杂的交通动态,同时尊重和利用数据的空间和时间异质性。本文提出了一个名字元图转换器(Meta Graph Transformer, MGT)的新框架解决这个问题。推广原始转换器,用于建模自然语言处理中的向量序列。具体来说,MGT有一个编码器-解码器架构。负责将历史交通数据编码为中间表示,回归预测未来的交通状态。MGT主要建筑模块是三种注意层,即注意时间(TSA)、注意空间关注(SSA)和时间编码器-解码器注意(TEDA)。它们都是多头结构。使用编码器和解码器TSA和SSA捕获时间和空间的相关性。采用TEDAs,在时间上,解码器中的每个位置都可以参与输入序列中的所有位置。使用多个图,稀疏空间可以利用各种诱导偏差来注意。从外部属性学习,以促进模型对时间和空间条件的感知时空嵌入(spatial - temporal Embeddings, sts),这些外部属性由时间属性(如顺序、一天的时间)和空间属性(如拉普拉斯特征映射)组成。这些嵌入是通过被所有的用它来赋予它层空间-时间异质性感知(STHA)的属性。在三个真实交通数据集上的实验证明了我们的模型比几种最先进的方法的优越性。

1. Introduction

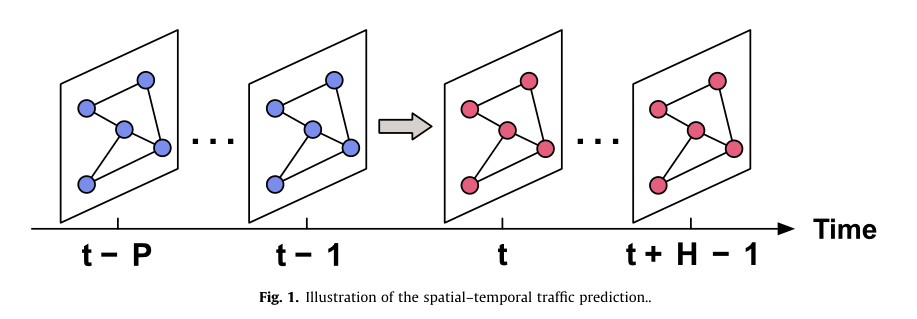

交通基础设施的发展和人们出行需求的不断变化,呼唤交通资源的有效优化和高效配置。解决这些问题的需要就投在了智能交通系统(ITS)领域。ITS的核心是两大支柱**:智能交通基础设施数据分析算法**。前者可以从各种设备(如环路检测器和地铁票价采集系统)收集大量交通数据,而后者在将交通数据转换为有用信息方面起着关键作用。交通量预测是智能交通系统(ITS)的基本任务之一。流量预测的是根据网络中所有位置的历史记录(即前 P P P个时间步的流量状态),预测网络中所有位置未来的流量状态(即下一个 H H H时间步的流量状态)。图1给出了时空交通预测的简要说明。准确的交通预测可以指导交通部门更好地管理和规划。然而,复杂的空间和时间相关性使这项任务具有挑战性。

在早期,统计模型在解决交通预测问题中很流行,比如自回归综合移动平均方法[1,2]、卡尔曼滤波[3]、向量自回归模型[4]。这些模型被严格的验证.然而,它们的性能往往受到可能不正确的交通数据假设(线性、平稳性等)的限制。

随后,各种被开发出来,如支持向量回归[5]、随机森林[6]、k最近邻模型[7]等。这些方法有能力建模非线性相关性和提取更复杂的相关性,特别是当大规模数据可用时。然而,这些模型的有效性很大程度上取决于复杂的特征工程,这可能是困难和耗时的。

近十年来,在图像识别[8,9]、目标检测[10,11]、机器翻译[12,13]等各个领域都带来了突破。深度学习的强大能力也吸引了交通领域的研究人员。将区域划分为网格,利用二维或三维(含时间维度)卷积进行交通预测[14-18]。但是,这种基于网格的方法没有考虑交通数据的底层图结构。另一个研究方向是时空图神经网络(spatial - temporal Graph Neural Networks, STGNNs)[19],其空间信息的交换是由图来引导的。这种方法最近很流行。典型的模型有STGCN[20]和DCRNN[21]。

顾名思义,STGNN框架通常涉及建模的两个方面:一个沿空间维度,另一个沿时间维度。这两个方面的建模可以分别进行[20,22-26],也可以同时进行[21,27 - 30]。后者的一种常见做法是将递归神经网络(RNN)中的矩阵乘法替换为图卷积。STGNN框架的主要挑战是有效捕获交通网络演化过程中复杂的时空相关性,从而尽可能提高预测的准确性。

在空间建模方面,许多工作都是在静态图[21,20]的基础上进行图卷积[31,32]。该图通常由真实的交通网络构建,其边权值从距离上反映了两个节点的接近程度。虽然基于距离的图在一定程度上揭示了地理位置接近的地点之间的相互影响,但它在远程建模[33]中是不足的。为了弥补这一缺陷,Graph WaveNet[22]和AGCRN[30]提出通过节点嵌入学习隐藏的空间依赖,而PVCGN[27]和Multi-STGCnet[23]从不同角度构建多个图进行空间特征学习。这些方法的问题是,在每个图(预先构建或学习)中,分配给相邻节点的权值在训练后是固定的。这种方法不适用于空间相关性会随时间变化的交通任务。因此,有研究者考虑利用注意力机制[12]来动态确定邻居的权重[34,28,24-26]。 通常,分配给邻居的注意系数是通过参数化函数计算的,中心节点的特征和相邻节点的特征作为输入输入输入到该函数中。这样,就可以用动态权重代替静态权重进行特征聚合,从而大大增强了模型的适应性。

然而,大多数基于注意力的方法都有一个显著的缺陷:参数在所有位置和时间间隔中是共享的,因此节点之间的相关性仅取决于它们各自的特征。为什么这很重要?假设有一对地铁站(图2):A站位于商业中心,B站位于居民区。,A站的出流量与b站的入流量高度相关,。 ( a , b ) (a,b) (a,b)和 ( c , d ) (c,d) (c,d)分别为7:00和14:00。前者是在高峰时间,而后者不是。交通数据在a和c处的值相同,同理b和d处的值也相同。如果相关性仅依赖于特征,那么a和c相关,b和d相关,然而事实并非如此。这表明空间相关性本质上是时间异质性的。此外,空间相关性还需要考虑空间异质性,典型交通网络中的不同节点甚至不具有相同的局部拓扑。因此,考虑到时空异质性似乎是空间建模的一个自然的改进方向。

在方面,现有的方法主要分为三类:🔥基于RNN的方法[21,23,28,27,30]、基于🔥cnns的方法[20,22,25]和基于🔥注意力的方法[34,24,26]。rnn[35,13]最早被提出用于自然语言处理,试图同时记忆长、短期信息。然而,由于[36]的梯度消失问题,RNN很难捕获长期依赖[37]。此外,rnn的顺序性使得其在训练时不可能被并行化。同时,基于CNNs的方法通过在时间维度上使用一维卷积[38]实现并行化。然而,受限于内核大小,一维卷积无法捕获长期依赖关系。尽管当足够多的一维卷积层堆叠在[39]时,任何时间点对最终都会被关联起来,但这种关联会被稀释,无法有效利用。相比之下,基于注意力的方法通过关注每个时间位置来有效地学习长期依赖,并且可以很容易地并行化。

就像空间建模一样,时空异质性可以被用来提高时间建模的性能。考虑图2中对 ( e , b ) (e,b) (e,b)和 ( f , d ) (f,d) (f,d),分别具有相同的时间跨度(1小时)和相同的值。因为 ( e , b ) (e,b) (e,b)取自高峰时段,它们的相关性应该强于 ( f , d ) (f,d) (f,d)。这种差异将被时空同质的方法所忽略。

沿着这条路线,一些作品[29,24,30,26]考虑了时空异质性。但他们要么在序列层次上考虑异质性[29,30,26],要么通过时空嵌入和输入(特征)的直接串联[24]或求和[29,26]引入异质性。前者无法合并全局时间信息,而后者混淆了两种不同类型数据之间的关系。

本文提出了一个(Meta Graph Transformer, MGT)框架来解决流量预测问题。管理行为在时间和空间维度上充分利用了。因此,它享有所有关注的好处,如动态关联、高效的长期建模和容易并行。此外,我们设计了一个元学习过程(因此被称为),将从中学习到的元知识整合到注意层中,从而使我们的模型能够执行时空异质性感知(STHA)注意。此外,我们的空间注意层集成了多个图,从而考虑了各种类型的空间相关性。我们的模型的贡献总结如下:

- 本研究开发了一个框架,将,以捕捉交通预测任务中的时空异质性。

- 将到空间-时间嵌入(spatial - temporal Embeddings, STEs)中,在此指导下设计了三种类型的注意层,在时间和空间维度上执行 STHA 操作.

- 创建了一个,以更好地捕捉不同类型的空间依赖关系。

- 在三个交通数据集上进行了大量实验,以评估我们提出的模型。结果表明,我们的模型明显优于最先进的方法。

2. Related Work

2.1. Spatial–Temporal Traffic Prediction

交通预测是ITS[40]中的经典任务,近年来已经取得了很大的进展[41-55]。早期的工作主要集中在统计方法 上,如[4]等。虽然这些模型有复杂的数学理论支持,但不切实际的假设,如线性和平稳性,限制了它们在交通预测中的表现。基于机器学习的[7]等方法克服了这些局限性。这些模型能够对更复杂的依赖关系进行建模,并受益于大规模数据。但是手工进行特征工程的需要使它们成为劳动密集型和耗时的。

深度学习 [56]通过自动提取网络中的表示,绕过了复杂的特征手工制作过程。受(Convolutional Neural Networks, CNNs)在图像任务上的巨大成功[8-11]的启发,交通社区的研究人员将感兴趣区域划分为[14-18],并将其视为具有卷积的图像。例如[14]利用基于cnn的残差神经网络来预测全市的人群流动。 [17]通过本地CNN和LSTM预测区域交通状态。[18]引入3D卷积,自动捕获交通数据在空间和时间维度上的相关性。

由于交通网络自然是图结构 的,许多研究人员考虑直接在图上建模交通数据。这些模型统称为STGNNs [19]。沿空间和时间维度的建模可以分别进行[20,22-26]或同时进行[21,27-30]。对于后者,一种常见的做法是[21,27,28,30],另一种方法是。

在空间建模方面,许多文献[21,20]采用了静态图上的局部图卷积[31,32],该静态图是由真实交通网络构建的。然而,由于其他交通关系,空间依赖可能是非本地的,如。为了解决这个问题,

[22]和[30]都通过节点嵌入学习了一个隐藏的空间依赖。 [27]构造一个物理图和两个基于领域知识的虚拟图来进行图卷积。 [23]设计了三个空间矩阵来提取目标站的空间相关性,将目标站的空间相关性分为近邻居、中邻居和远邻居。

上述方法的共同点是,在测试阶段,每个图上的边权值都是固定的。但实际上,节点之间的空间关系可能会随着时间的推移而改变。为了进一步提高空间建模的适应性,许多研究利用关注机制[12]根据输入动态分配边缘权值。

【34】使用空间注意机制【57】捕捉动态空间相关性。 [28]利用多范围注意机制,有效地利用多个范围信息,生成集成表示。 [25]提出了一种基于门控机制的图关注网络cosat,用于捕获空间信息。 [24]和[26]采用scale - dot - product attention机制对空间相关性进行建模。

关于时间建模,现有的方法主要分为三类:基于RNN的方法、基于CNNs的方法和基于注意力的方法。 🌽基于rnn的方法[21,23,28,27,30]通常利用长短期记忆 )[35]或门控循环单元()[13]作为时间建模的基本块。一些研究[21,28,27,30]通过,以同时捕获空间和时间相关性。虽然rnn被提出用于建模长序列,但由于梯度消失问题[36],它们在捕获长期依赖[37]方面实际上效率很低,而且它们的序列性质使得训练过程中不可能实现并行化。 🌽相比之下,基于cnns的方法[20,22,25]很容易并行化。[20]和[25]使用一维卷积[38]进行时间特征学习。[22]通过叠加多个扩张的1D卷积[39]指数级放大接收野。然而,长期的相关性将被如此稀释,以有效地利用。 🌽基于注意力的方法[34,24,26]以并行的方式参与每个时间位置,这使它们能够胜任长期建模。

一些研究[29,24,30,26]考虑了时空异质性 。通常,

- [29]具有针对不同时间段的多个内置模块,以捕获本地化的时空图中的异构性。

- [30]在传统GCN的基础上增加了节点自适应参数学习模块。

- [24]在进行缩放点积方法之前将时空嵌入与特征连接起来。>

- [26]在输入中加入了时间嵌入和空间嵌入来引入异构性。

对于STSGCN、AGCRN和ASTGNN,考虑的异质性是相对于输入序列的,因此与内在的时间属性无关。此外,通过直接求和29,26将外部时空属性与输入(特征)融合似乎是不合理的,因为它们本质上是两种不同类型的数据。

2.2. Attention Mechanism

注意机制[12,58]最早被提出用于神经语言建模。它使查询能够自适应地参与和聚合值集合。在算法上,分配给每个值的权重是由查询的兼容函数和与该值相关的相应键计算出来的。近年来,注意力机制为许多任务带来了很大的改进,如自然语言处理[59],图像字幕[60],语音识别[61]和多元时间序列分析[62]。在交通领域,注意力机制在交通数据动力学建模中也显示出了其有效性。近期工作包括ASTGCN[34]、MRA-BGCN[28]、LSGCN[25]、GMAN[24]、ASTGNN[26]。

当查询queries, 键 keys 和 值values 相同时,注意力就变成了自我关注。相对于RNN和CNN,自注意作为一种序列表示学习方法,具有全局的接受域,通过并行化可以有效地执行。这些特性赋予了它强大的长序列建模能力。此外,通过使用多头注意[58],它能够学习,使得建模更加灵活。

3. Preliminaries

3.1. Problem Formulation

在本节中,我们介绍了一些定义,并建立了交通预测问题。 Definition 1 (Traffic Network) :交通网络是一个有向图 G = ( V , E , A ) \mathcal{G}=(V,E,A) G=(V,E,A),其中 V = { v 1 , v 2 , ⋯ , v N } V=\{v_1,v_2,\cdots,v_N\} V={ v1,v2,⋯,vN}是 N N N个节点的集合表示交通系统中的点(例如,道路传感器、路段、十字路口、地铁站), E E E是一个有向边的集合,其中 ( v i , v j ) (v_i,v_j) (vi,vj)表示从 v j v_j vj指向 v i v_i vi的有向边, A A A表示邻接矩阵: A ( i , j ) = { 1 , i f ( v i , v j ) ∈ E 0 , e l s e o t h e r w i s e f o r i , j = 1 , ⋯ , N (1) A(i,j)=\begin{cases}1,& if (v_i,v_j) \in E\\0, & else \ otherwise\end{cases} for\quad i,j=1,\cdots,N \tag{1} A(i,j)={ 1,0,if(vi,vj)∈Eelse otherwisefori,j=1,⋯,N(1)

Definition 2 (Traffic States) : 节点 i i i在时刻 t t t的交通状态用 X t i ∈ R C \mathcal{X}_t^i \in R^C Xti∈RC,其中 C C C表示featrues的number.所有节点的在时刻 t t t的状态用 X t = [ X t 1 , ⋯ , X t N ] ∈ R N × C \mathcal{X}_t=[\mathcal{X}_t^1,\cdots,\mathcal{X}_t^N] \in R^{N\times C} Xt=[Xt1,⋯,XtN]∈RN×C.

Definition 3 (Temporal Attributes): 每个时间间隔 t t t附加几个时间属性,如一天中的时间、一周中的哪一天和休息日指示器。假设有 M M M个可用的时态属性。时间间隔t的第 m m m个属性记为 T t m = { 1 , 2 , ⋯ , N m } T_t^m=\{1,2,\cdots,N_m\} Ttm={ 1,2,⋯,Nm},其中, N m N_m Nm表示可能的状态。

Definition 4 (Multiple Graphs): 基于特定的领域知识(距离、相似度等),可以构建来解释节点之间的不同关系(详见4.3.1节)。这些图被表示为 { G b = ( V , E b , W b ) b = 1 B } \{\mathcal{G}_b=(V,E_b,W_b)_{b=1}^B\} { Gb=(V,Eb,Wb)b=1B},其中 E b E_b Eb表示为边集, W b W_b Wb表示为 G b \mathcal{G}_b Gb的权重矩阵, B B B表示graph的可能的数量。所有的图共享节点集合 V V V.

Proof. 给定过去P时间间隔内的历史交通状态 X = [ X t − P , X t − P + 1 , ⋯ , X t − 1 ] ∈ R P × N × C (2) \mathcal{X}=[\mathcal{X}_{t-P},\mathcal{X}_{t-P+1},\cdots,\mathcal{X}_{t-1}]\in R^{P\times N \times C} \tag{2} X=[Xt−P,Xt−P+1,⋯,