原文链接:「学习路线」SLAM/深度估计/三维重建/校准/传感器融合/…(本文较长,建议收藏)

粉丝们经常问视觉/激光/SLAM、这里我将向大家总结三维重建的学习路线,如下所示:

近年来,智能机器人、自动驾驶AR/MR等领域的快速发展,企业3D视觉算法及SLAM该领域的算法需求越来越强劲,迎来了爆炸性的发展。

根据不同的应用,我们将33D视觉及SLAM算法分为以下方向:

-

视觉深度估计

-

视觉(惯性)SLAM

-

激光/多传感器融合SLAM

-

三维重建几何/深度学习

-

视觉传感器校准

以下分别介绍(本文较长,建议收藏):

视觉深度估计

视觉深度估计的目的是估计图像中场景的深度,即从场景中的点像素到相机成像的垂直距离,分为绝对距离和相对距离。让我们看看下面的例子,左边是原始图片,右边是算法估计的相应深度图:

最近?年,?动驾驶 、?机器交互、虚拟现实、机器发展非常迅速,尤其是视觉案在?在驾驶中取得惊人的效果,应该是吗?如何在场景中获取深度信息是关键和必要的。同时,从深度图中获得前后关系更容易区分物体的边界,简化CV许多任务算法,如3D?标准检测、分割、场景理解等。相?在激光雷达测距方面,相机价格低廉,体积小,操作简单。目前,视觉深度估计是三维视觉最重要的基本模块之一,不仅在学术领域CV会议上有许多关于相关新论文的深入估计,在工业界也得到了广泛的应用。这是一项流行的研究向。

深度估计在自动驾驶领域的应用

视觉(惯性)SLAM

SLAM指机器人、无人机、手机、汽车等移动设备 穿戴设备等)) 从未知环境中的未知地点出发 发, 通过传感器(如相) 机器,激光雷达, IMU等)观测定位 自身位置和姿态,再根据自身位 增量地图构建姿势, 从而实现定位和地图构建 目的。SLAM技术是智能机器人,自动驾驶汽车AR/MR其他领域的底层核心技术之一。

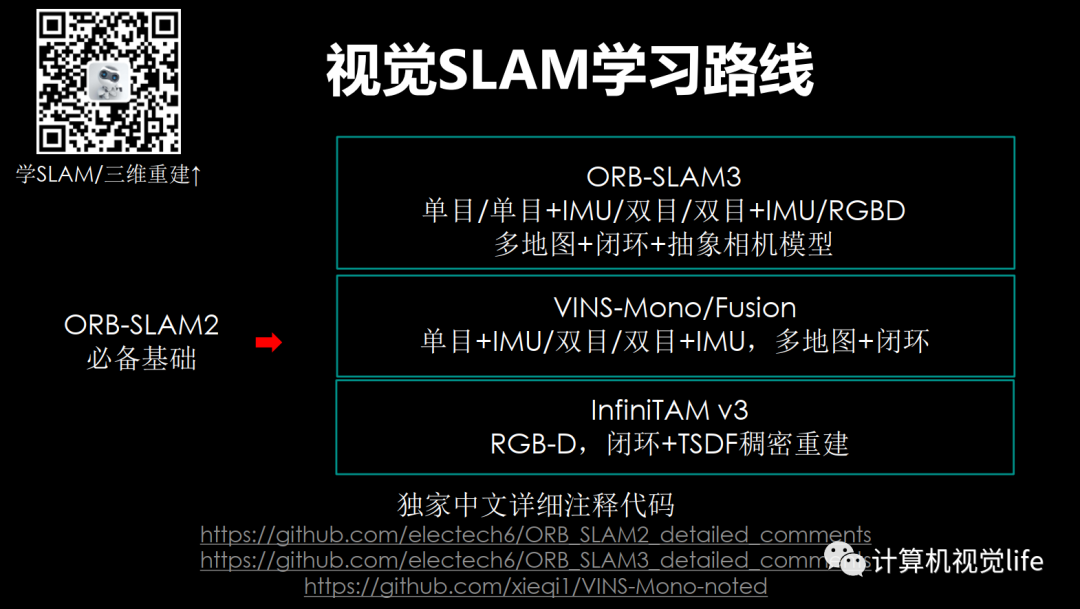

如果SLAM视觉相关传感器(如单目、双目、RGB-D、鱼眼、全景相机)一般称为视觉SLAM。最著名、最有效的视觉SLAM是ORB-SLAM2/3系列和VINS-Mono/Fusion系列。

2015年,西班牙萨拉戈萨大学机器人感知与实时研究小组开源ORB-SLAM第一个版本因其卓越的效果而受到广泛关注。该团队在2016年和2020年开源了第二个版本ORB-SLAM二、三版ORB-SLAM3。

其中ORB-SLAM2是业内最著名、应用最广泛的开源代码。它有以下优点:

-

支持单目,双目和RGB-D相机的完整开源SLAM该方案可实现地图重用、回环检测和重新定位。

-

支持轻量级定位模式,可以达到零漂移,此时不使用局部建图和回环检测的线程,可以用视觉里程计来跟踪未建图区域。

-

采用ORB特点是旋转不变、光不变、规模不变、匹配速度快,适合实时应用。无论是室内小型手持设备,还是无人机和城市驾驶的汽车,ORB-SLAM2都能够在CPU实时工作。

-

跟踪、局部地图、闭环、重定位等所有任务都使用相同的任务ORB使系统中的数据交互更加高效、稳定、可靠。

-

无论是平面还是非平面场景,单目初始化和应用场景解耦都可以自动初始化,无需人工干预。

-

地图点和关键帧创建相对宽松,但后续将进行严格筛选,消除冗余关键帧和误差大的地图点,提高施工过程的弹性,在大旋转、快速运动、纹理不足等恶劣条件下提高跟踪的鲁棒性。

-

采用共视图,使跟踪和构图控制在局部共视区,与全局地图大小无关,可在大场景下运行。

-

使用本质图(Essential Graph)优化位置,实现回环检测,耗时少,精度高 。

-

与直接法相比,可用于宽基线特征匹配,更适合对深度精度要求较高的场景,如三维重建。

-

定位精度高,可达厘米级,是特征法SLAM经典代表作。

-

代码可读性强,工程技能多,非常实用。

下面是ORB-SLAM2的算法框架

ORB-SLAM2 应用于汽车

ORB-SLAM2 用于室内三维重建

ORB-SLAM三是特征点法SLAM经典之作ORB-SLAM它是在2020年7月发布的。它在定位精度和效果上几乎粉碎了类似的开源算法,被称为VIO算法的巅峰之作。受到极大关注。该算法流程图如下所示

该算法的特点如下:

-

1、 第一个可以运行视觉、视觉惯性和多地图,支持单目、双目和RGB-D相机支持针孔和鱼眼镜头模型SLAM系统。

-

2.该算法可以在不同大小、室内外环境中实时运行,精度比以前的方法提高2~5倍。

-

3、 多地图系统可以使系统在缺乏视觉信息的情况下长时间运行。例如,当跟踪丢失时,它将重新的地图,并在重新访问之前的地图时与之前的地图无缝合并。

-

4.实验结果表明,该算法在无人机数据集中EuRoC能达到平均3.6cm在手持设备快速移动的室内数据集中,定位精度TUM-VI上达到了9mm定位精度。

先直观看视觉效果

看 ORB-SLAM3 疯狂的绕圈,非常稳定!甚至滑梯也穿过黑管!

丝滑闭环从室内到室外

ORB-SLAM3效果展示

以上是定性结果,下图是量化结果。

从统计数据来看,ORB-SLAM3确实碾压了类似的算法。功能强大到让步。SLAM算法研究人员感叹做你想做的一切

VINS即Visual-Inertial navigation Systems,它是视觉惯性导航系统的总称,但我们通常所说的VINS-Mono/Fusion。2018年,香港科技大学飞行机器人实验室(沈邵杰团队)开源VINS-Mono算法。第一作者秦通(2019年华为天才少年)获得2018年机器人顶级期刊IEEE Transactions on Robotics最佳论文奖。它使用单目相机 惯性测量单元(Inertial Measurement Unit,简称IMU)在保证高精度里程计效果的同时,还可以同时估计传感器外参,实现紧耦合的视觉和惯性联合状态估计,IMU零偏差和传感器延迟。该团队于2019年开源VINS-Mono的升级版VINS-Fusion,它支持包括单目在内的各种视觉惯性传感器类型 IMU,双目 IMU,纯双眼。VINS-Mono和VINS-Fusion当年一骑绝尘,非常经典优秀VIO框架。

以下是VINS-Mono效果显示,室外大规模效果也很好,以下是它在香港科技大学操场上的SLAM效果:

在手机AR该算法击败了目前最先进的应用Google Tango效果如下:

以下是VINS-Fusion在汽车SLAM上的效果:

激光/多传感器融合SLAM

如果SLAM该过程主要使用与激光雷达相关的传感器,通常称为激光SLAM。最著名、最有效的激光SLAM是Google发布的Cartographer,以及LOAM、LEGO-LOAM。

Cartographer是一套推出的基础的激光SLAM它同时支持算法,可跨平台使用,支持。是目前的激光SLAM算法之一。

Cartographer建图过程

Cartographer最重要的代码 贡献,而是**实现工程太好了!**它不依赖PCL,g2o, iSAM, sophus, OpenCV等第三方库,所有轮子都是自己做的,2D/3D的SLAM核心部分仅依赖于Boost、Eigen(线性代数库),Ceres(Google开源非线性优化库)等几个底层库。

这显然不是从事科研的玩法,而是奔向产品!,可以直接在应用,关键是,而且!大大降低了开发者的门槛。目前正在GitHub的star数量很高。

因此Catographer非常适合于场景的实时定位和建图。

如果SLAM过程使用了3种以上传感器,比如视觉、激光、IMU、GPS等,一般称之为多传感器融合SLAM。比较知名的是LIO-SAM、LVI-SAM、R3LIVE等。

LIO-SAM 是Tixiao Shan在LeGO-LOAM的扩展,添加了IMU预积分因子和GPS因子:前端使用紧耦合的IMU融合方式,替代原有的帧间里程计,使得前端更轻量;后端沿用LeGO-LOAM,在此基础上融入了GPS观测。同时前端后端相互耦合,提高系统精度。

LIO-SAM效果展示

几何/深度学习三维重建

指用相机拍摄真实世界的物体、场景,并通过计算机视觉技术进行处理,从而得到物体的三维模型。常见的重建方法包括视觉几何三维重建,以及最近的基于 深度学习的三维重建。它是增强现实(AR)、混合现实(MR)、机器人导航、自动驾驶等领域的核心技术之一。三维重建通常需要SFM或者SLAM得到的位姿和地图点作为输入条件,下图是视觉三维重建的基本流程:

视觉几何三维重建效果展示

根据不同的实现方法,我们可以将三维重建分为:基于几何的三维重建和深度。具体细分如下所示:

传统的重建方法是使用光度一致性等来计算稠密的三维信息。虽然这些方法在理想的Lambertian场景下,精度已经很高。但也有一些常见的局限性,例如等,使得。因此,传统三维重建方法在重建的完整性等方面仍有很大的改进空间。

近年来深度学习在三维重建上取得了很大的成功。基于学习的方法可以引入比如,从而解决传统方法无法克服的难题。因此掌握基于深度学习的三维重建前沿算法非常重要。另外,在这个大数据时代,深度学习已经是大家必须掌握的技能,传统视觉算法已经很难有新的突破,各个领域都在朝深度学习方向研究,近几年各大视觉会议论文都是基于深度学习来实现三维重建,各个大厂招聘也越来越看重深度学习三维重建方法。

下图是我们整理的深度学习MVS网络演化图:

下面学习路线以深度学习MVS网络演化图为主线,重点讲解三个优秀的开源框架 (经典的深度学习MVS开源库)、(有监督MVS网络中最新最佳)、(无监督MVS网络中最新最佳),并梳理各种变种网络,。

视觉传感器标定

包括常见的单目/鱼眼/双目/阵列相机标定。相机标定是指借助专用的标志物(如棋盘格)来估计相机的图像传感器参数(内参、外参)和镜头参数(畸变系数)。相机标定是一切三维视觉的基础。它广泛应用于双目视觉、手眼机械臂、机器人定位建图、图像拼接、三维重建等场景。

相机标定学习路线

以上所有教程,我们都有对应的源码解析课程。

欢迎进入店铺查看↓

店铺链接:「学习路线」SLAM/深度估计/三维重建/标定/传感器融合…(本文较长,建议收藏)

独家重磅课程!

1、详解Cartographer源码:多LiDAR时间同步/去畸变、IMU里程计融合、点云匹配、分支定界。。。

2、深度学习三维重建 详解深度学习三维重建网络:MVSNet、PatchMatchNet、JDACS-MS

3、三维视觉基础 详解视觉深度估计算法(单/双目/RGB-D+特征匹配+极线矫正+代码实战)

4、视觉SLAM必备基础 详解视觉SLAM核心:地图初始化、实时跟踪、局部建图、回环检测、BA优化,工程技巧

5、 VINS:Mono+Fusion SLAM面试官:看你简历上写精通VINS,麻烦现场手推一下预积分!

6、VIO进阶:ORB-SLAM3(单/双目/RGBD+鱼眼+IMU紧耦合+多地图+闭环)独家70+讲全部上线!

7、图像三维重建课程:视觉几何三维重建教程(第2期):稠密重建,曲面重建,点云融合,纹理贴图

8、重磅来袭!基于LiDAR的多传感器融合SLAM 系列教程:LOAM、LeGO-LOAM、LIO-SAM

9、系统全面的相机标定课程:单目/鱼眼/双目/阵列 相机标定:原理与实战

链接:「学习路线」SLAM/深度估计/三维重建/标定/传感器融合…(本文较长,建议收藏)

全国最棒的SLAM、三维视觉学习社区↓

链接:「学习路线」SLAM/深度估计/三维重建/标定/传感器融合…(本文较长,建议收藏)